Inteligência Artificial Expõe Estereótipos e Preconceitos Embutidos Em Conjunto De Dados

Apesar das excelentes ferramentas criadas, ainda há problemas a serem enfrentados, como os tipos de dados captados.

Um aplicativo que usa a mesma lógica dos programas de relacionamento, mas para “fazer” ciência. Este é o Braindr, programa usado para controle de qualidade de imagens do cérebro. Em formato de jogo, tem um objetivo simples: classificar as imagens conforme a sua qualidade: deslizando-a para a direita se a imagem for de boa qualidade ou para a esquerda se ela for ruim. Para cada imagem que o jogador acertar, ganha um ponto e seu nome aparece em uma tabela de classificação. O jogador com mais pontos tem 6251 pontos atualmente.

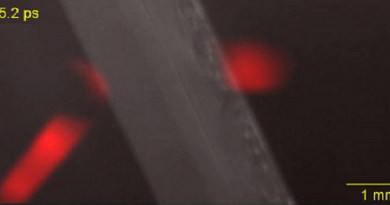

Anisha Keshavan, estudante de pós-doutorado da Universidade de Washington, nos Estados Unidos, que estuda o cérebro através de grandes conjuntos de imagens captadas através de ressonância magnética e que desenvolveu o aplicativo, afirma que “O problema com grandes conjuntos de dados é que muito do nosso processo depende de checagem manual. O gargalo é inspecionar visualmente o processamento dessas imagens”.

Como esse é um problema comum aos laboratórios que trabalham com neuroimagem, quando Keshavan estava conversando com seus amigos, surgiu a ideia de fazer um aplicativo similar àqueles de relacionamento, onde você apenas desliza uma foto para “dar like” ou não no perfil de alguém, e utilizá-lo para classificar neuroimagens. Mas nem ela levou a sério. “Eu disse, “ah galera, isso não faz nenhum sentido, ninguém irá jogar”. Mas elaborei o programa num final de semana, postei no Twitter e fez muito sucesso! Agora nós temos cem mil “swipes” nessas imagens”, contou. E quando cientistas, como Keshavan, têm dados suficientes, é possível começar a treinar o aprendizado de máquina. Para bons resultados.

Treinando máquinas

Uma das áreas da inteligência artificial (IA) que mais tem feito sucesso é chamada de aprendizado de máquinas. Nela, o sistema se adapta, aprende com o ambiente ou conjunto de dados ao qual ele foi submetido – como no caso das neuroimagens do Braindr. “A ideia é ter sistemas capazes de aprender com a experiência de onde estão inseridos. O que, de certa forma, é a definição de inteligência humana – ser capaz de se adaptar e responder às diversas mudanças do meio”, explica Esther Luna Colombini, professora do Instituto de Computação da Unicamp.

O trabalho na área de IA pode seguir diferentes modelos. Existe o paradigma simbólico, que trabalha com lógica, símbolos, com sistemas dedutivos e indutivos. Há também o modelo conexionista, que utiliza redes neurais, imitando o padrão de funcionamento do cérebro. A partir dessa “imitação”, os pesquisadores utilizam conjuntos de dados, normalmente muito grandes, para inferir uma função que seja capaz de, dado um objeto de entrada, reportar um resultado na saída desse sistema.

“É como se eu colocasse uma foto de um gato e, na saída, o programa me dissesse que aquilo é um gato. Isso desde que eu tenha treinado esse sistema com inúmeras fotos de gatos diferentes”, explica Colombini, que completa “é submeter o algoritmo ao ambiente e às tarefas aos quais ele será aplicado”.

A escala atual de atuação da IA é focada na solução de pequenos problemas ou de problemas isolados, em diferentes áreas. É possível realizar desde o reconhecimento de um objeto, passando pela identificação de uma imagem médica para saber se é um tumor benigno ou maligno, até chegar na recomendação de um serviço para o consumidor baseado no histórico de compras dele.

O que dizem os dados?

Independentemente da finalidade do algoritmo que está sendo construído, ele precisará de dados para ser treinado. Os dados podem ser gerados por aplicativos de ciência cidadã, vir de seu histórico de compras, ou, ainda, via redes sociais. E o que parece inofensivo, na verdade, pode ser um grande problema.

Em 2016, a Microsoft inaugurou uma conta no Twitter, a Tay, para testar seu programa de inteligência artificial. O resultado foi desastroso. Por ela interagir e aprender com os humanos, Tay fez comentários racistas, preconceituosos e chegou a afirmar que o holocausto foi uma invenção. Tudo isso após apenas um dia na rede.

“No momento, a IA é inteiramente dependente de dados. Se os dados são ruins, o sistema é ruim, se os dados são sexistas, o sistema é sexista”, comenta a professora Colombini. A americana Catherine O’Neil, que já passou por diferentes instituições de ensino nos Estados Unidos e trabalhou no mercado financeiro, afirma que os algoritmos podem reforçar estereótipos da sociedade.

Em entrevista, O’Neil conta sobre seu livro Armas de destruição matemática, lançado em 2016, em que alerta sobre usos deturpados dos algoritmos. “O que me preocupa como especialista em matemática é o marketing em torno desses algoritmos. Dizem que eles estão ajudando a tornar o mundo mais justo por se basear em modelos matemáticos. Mas vivemos numa sociedade historicamente racista, sexista. Os exemplos do meu livro mostram que os algoritmos podem estar apenas ajudando a reforçar esses estereótipos. E, ao acharmos que eles resolvem determinado problema, paramos de nos preocupar”, afirma O’Neil.

A discussão em torno do viés que existe em conjuntos de dados é presente no meio acadêmico e nas empresas que trabalham com IA. Apesar de a aplicação da IA ainda estar distante de atuar em sistemas muito complexos ou que reproduzam com fidelidade o comportamento humano, a discussão é importante, atesta Colombini.

“Algumas pesquisas buscam sistemas mais generalistas. E que a IA fosse mais ou menos como é o ser humano. Nós temos os nossos vieses (bias), os nossos direcionamentos, mas somos capazes de ultrapassá-los e rever nossos conceitos”, afirma a professora.

Por Maria Letícia Bonatelli

Fonte: Com Ciência